Negli ultimi giorni, mentre il mondo mediatico celebrava la nascita di ChatGPT Health — nuova sezione dedicata alle domande di salute dentro l’universo di ChatGPT — è emersa con forza una domanda a cui nessuna AI può davvero rispondere: perché sempre più persone preferiscono rivolgersi a un algoritmo piuttosto che a un medico?

Una alternativa (pericolosa) alla mancanza di medici

La risposta non è semplice, ma una parte consistente si trova nelle pieghe di un sistema sanitario allo stremo. Negli Stati Uniti, la scadenza dei sussidi federali dell’Affordable Care Act (ACA) alla fine del 2025 ha spinto milioni di cittadini a riconsiderare la loro capacità di accedere a cure mediche tradizionali. Con premi che schizzano alle stelle e circa 12 milioni di persone a rischio di perdere la copertura sanitaria o vederla drasticamente ridotta, i cittadini si ritrovano a navigare in un sistema sempre più complesso e costoso.

Oltre 40 milioni di persone nel mondo utilizzano ChatGPT ogni giorno per questioni di salute

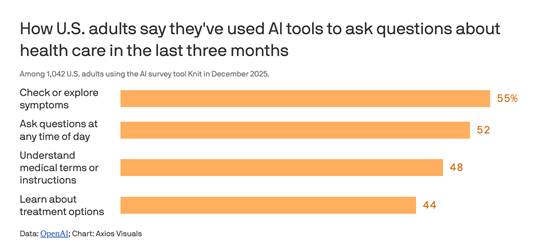

In questo vuoto, ChatGPT non è più solo un passatempo digitale: secondo un’indagine i cui risultati sono stati rilasciati da OpenAI e Axios a inizio gennaio, oltre 40 milioni di persone nel mondo utilizzano ChatGPT ogni giorno per questioni di salute, interrogandolo su sintomi, piani di assicurazione, costi per le cure private e persino strategie per gestire cure e visite. Negli USA, più in dettaglio, va per la maggiore interrogare l’algoritmo sul significato di alcuni sintomi a qualsiasi ora del giorno e della notte, così come ci si rivolge a lui per comprendere il “medichese” oltre che per cercare opportunità di trattamento per questo o quell’altro problema di salute (un po’ come si era soliti fare con “Dr Google”).

«Il problema principale di questi strumenti è che si cerca di far passare il loro impiego, non regolamentato, come strumenti di informazione e non come strumenti in grado di fornire suggerimenti diagnostici. Ma il confine tra informazione e diagnosi è estremamente delicato. Che cosa significa, infatti, “fornire un’informazione” a un paziente? Il paziente chiede informazioni per ottenere indicazioni su un possibile trattamento o su una possibile diagnosi. Si può anche spiegare che lo strumento non deve essere usato per fare diagnosi, ma nella pratica le persone lo utilizzeranno proprio per questo», riflette in modo lucido Eugenio Santoro, Direttore dell’Unità per la Ricerca in Sanità e Terapie digitali all’Istituto Mario Negri di Milano.

La casa madre precisa che non è uno strumento di diagnosi o trattamento

Ad ogni modo, la casa madre descrive ChatGPT Health come uno spazio “disegnato per aiutare gli utenti a sentirsi più informati, preparati e sicuri nel navigare la propria salute” — con possibilità di collegare cartelle cliniche elettroniche e app di benessere come Apple Health o MyFitnessPal. Promette crittografia avanzata, conversazioni separate e protezione dei dati sensibili. Ma precisa anche che non è uno strumento di diagnosi o trattamento medico. Come a dire, mettiamo le mani avanti per delegare la responsabilità dell’uso dello strumento all’utente. Perché, di fatto, la scelta di condividere dati sanitari – quanti e quali – dipende solo dall’utente.

Attenzione: non è un dispositivo medico

Ma sorge spontanea anche un’altra domanda: perché stiamo progressivamente abbandonando quel vecchio rituale di cercare su “Dr Google” risposte sanitarie generiche, per affidare la nostra salute a un’intelligenza artificiale che personalizza i consigli sulla base dei nostri dati?

In teoria, ChatGPT Health può aiutare a interpretare esami, prepararsi a una visita, capire i costi di assicurazione. In pratica, ci stiamo abituando a un confine pericolosamente labile tra informazione e diagnosi, tra orientamento pratico e sostituzione del medico. Anche se OpenAI insiste sul fatto che l’AI non debba sostituire il personale sanitario, nella realtà dei fatti è proprio questo che sta accadendo nella quotidianità. Specie per coloro che non hanno possibilità di accedere alle cure o di confrontarsi con un medico. Che, tradotto, significa negli USA per quanti non hanno l’assicurazione medica perché sono senza lavoro o la perderanno a causa delle discutibili politiche sanitarie messe in atto dalla politica trumpiana. Analogamente, anche in altri Paesi in cui l’accesso alla salute è un diritto garantito solo in base al censo, avremo sempre più persone che cercheranno di fare autodiagnosi e autocura interfacciandosi con un algoritmo.

«Non vogliono farlo passare come dispositivo medico perché giocano sul fatto che “fornisce solo informazioni”», evidenzia Santoro. Tuttavia, «anche se rimanesse uno strumento informativo, dovrebbe comunque essere coerente con l’AI Act europeo. E in alcuni aspetti non lo è, perché non essendo deterministico e non fornendo spiegazioni sul perché produce certi suggerimenti, potrebbe non ottenere il via libera nemmeno come strumento informativo. Quello che mi preoccupa è che questo strumento venga “venduto” come risposta a bisogni reali: abbiamo bisogno di assistenti, perché il sistema sanitario non riesce a rispondere a tutto».

Il rischio reale di prendere enormi cantonate

E il rischio di errore di fatto è altissimo. Giacché sappiamo che l’algoritmo risponde in modo tanto migliore quanto migliore è il “cibo” – cioè le informazioni – con cui viene “alimentato”. E così, è facile intuire quale mole e quale gravità di errori potranno uscire da questo confronto: la condivisione – magari parziale, magari non adeguata — di dati sanitari del paziente, l’algoritmo che restituisce una risposta con larga probabilità incompleta o viziata da quanto avrà “imparato” in modo stocastico in base ai dati con cui sarà venuto in contatto e un paziente che con difficoltà sarà in grado di leggere in modo critico l’output. Perché, seguendo il ragionamento, la mancanza di lavoro e quindi di assicurazioni che permettano l’accesso alla sanità è spesso direttamente proporzionale al livello di scolarità.

Ecco il cuore critico della questione: quando un sistema pubblico o privato non riesce a garantire assistenza accessibile e comprensibile, l’utenza si rivolge a strumenti che danno risposte rapide, personalizzate e, soprattutto, gratuite o a basso costo. L’AI diventa così la medicina di fatto di chi non può permettersi di aspettare un appuntamento, o semplicemente non ha chiaro come districarsi tra polizze, fatture e codici diagnostici.

L’AI diventa così la medicina di fatto di chi non può permettersi di aspettare un appuntamento

Ma come ogni cura fai-da-te, anche questa ha i suoi rischi. I modelli linguistici possono “prendere degli abbagli”— generare risposte convincenti ma inaccurate — soprattutto in ambiti delicati come la salute mentale o condizioni mediche complesse. Inoltre, non tutti gli algoritmi sono creati uguali, e fidarsi ciecamente di un’intelligenza che non è vincolata alla deontologia medica può trasformare curiosità in pericolo.

Come sottolinea Santoro: «Il rischio principale è che si dia ai cittadini la percezione di poter interagire con uno strumento che “sembra” fornire risposte corrette. Ma la letteratura scientifica mostra che, nella maggior parte dei casi, queste risposte non sono corrette. Per dimostrarne l’affidabilità servirebbero studi scientifici rigorosi. Studi che, ad oggi, non esistono».

Il nodo della privacy dei dati sanitari

Infine, resta la questione della privatizzazione dell’esperienza sanitaria: non stiamo solo scaricando risposte da una chat. Stiamo trasferendo le nostre paure, i nostri dati, le nostre vulnerabilità in spazi digitali controllati da aziende che, seppur etiche nelle promesse, rispondono a logiche di mercato prima che di cura.

Commenta Santoro: «OpenAI stessa non lo nasconde: questi sistemi saranno sviluppati per accedere — oggi negli Stati Uniti, domani forse anche in Europa — a cartelle cliniche, fascicoli sanitari elettronici, dati archiviati nei telefoni. È vero che i dati verrebbero caricati volontariamente dall’utente e non prelevati automaticamente. Ma il punto non è tanto come vengono acquisiti, quanto il fatto che il paziente affidi informazioni estremamente sensibili a questi sistemi. Anche se viene dichiarato che i dati sanitari non saranno usati per addestrare il modello, è una promessa piuttosto debole». Andremmo, insomma, verso «un contesto di privacy praticamente inesistente: io fornisco tutti i miei dati sanitari a un sistema che potrebbe usarli contro i miei stessi interessi. Non mi sembra una situazione rassicurante».

Resta da vedere se riusciremo davvero a difendere l’AI Act da pressioni esterne

In Europa, però, esiste l’AI Act come forma di tutela. Quindi una maggiore protezione normativa rispetto agli USA. Eppure, avverte il ricercatore del Mario Negri: «Resta da vedere se riusciremo davvero a difendere l’AI Act da pressioni esterne. Queste cose non accadono mai per caso: ci sono interessi economici enormi in gioco. Non a caso, l’annuncio di ChatGPT Health è arrivato il giorno dopo che la Food and Drug Administration statunitense ha di fatto deregolamentato gran parte dei sistemi di intelligenza artificiale, eliminando l’obbligo di approvazione come dispositivi medici. Questo spiega molto. Io vedo una scarsa attenzione alle conseguenze e ai pericoli, in controtendenza rispetto a quanto avviene in altri ambiti simili».

In un mondo in cui ogni clic può essere interpretato come sintomo o patologia, la promessa di una salute “a portata di chat” è innegabilmente attraente. E se da un lato ChatGPT Health può alleggerire il peso di domande semplici o burocratiche, dall’altro rischia di diventare l’ultima risorsa di chi non ha altra scelta. La domanda che resta, allora, non è se l’AI può “curare”, ma se noi stiamo curando la tecnologia invece della nostra sanità pubblica e privata.

Se l’AI diventa il medico di tutti, è forse perché il medico di nessuno è più accessibile di una sanità che in diversi Paesi non è un diritto che i cittadini possono pretendere?